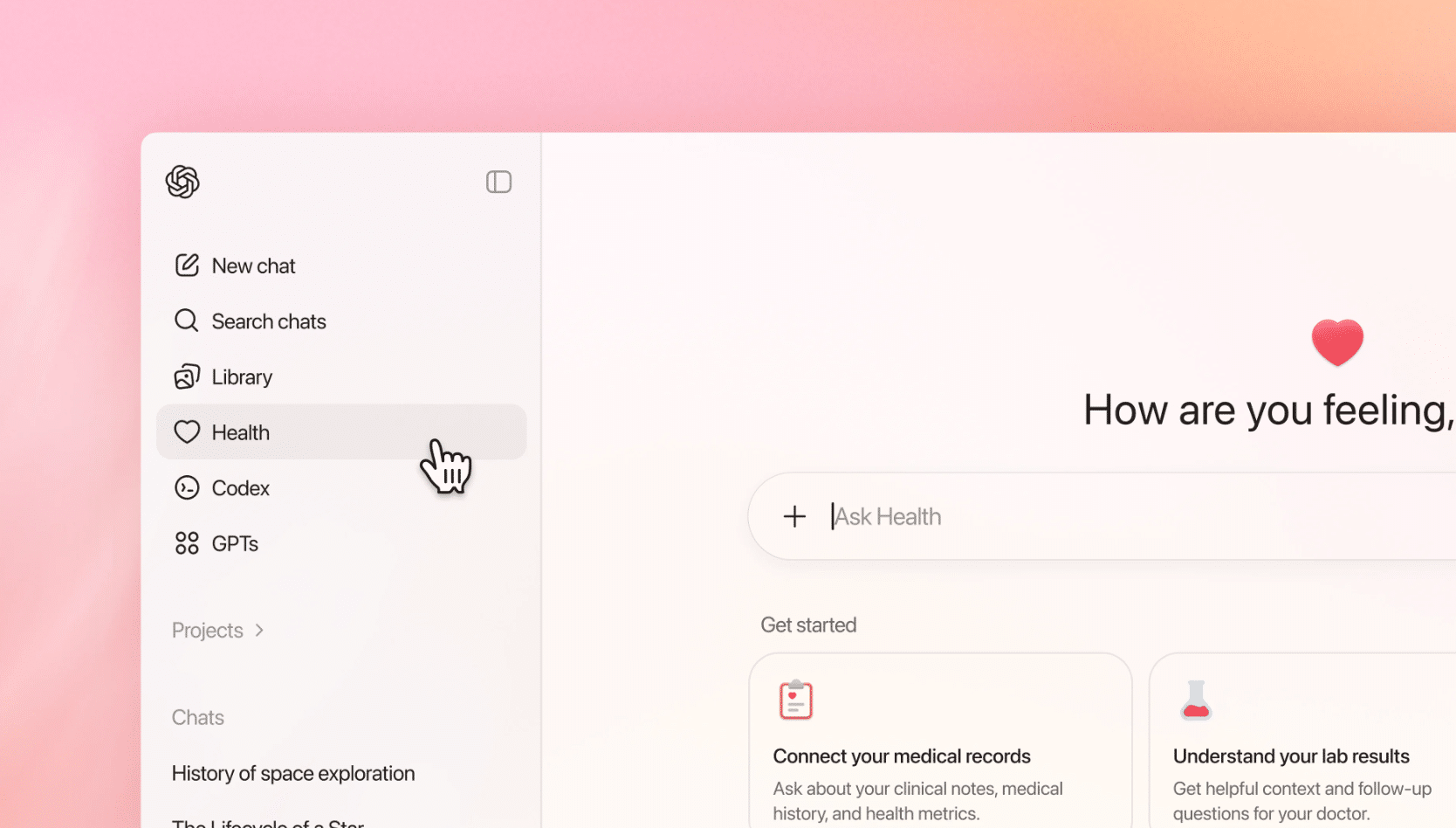

Η OpenAI παρουσίασε πρόσφατα ένα νέο χαρακτηριστικό μέσα στο ChatGPT που ονομάζεται ChatGPT Health και επιτρέπει στους χρήστες να συνδέσουν προσωπικά τους ιατρικά αρχεία και δεδομένα από wellness apps (όπως Apple Health, MyFitnessPal, Peloton κ.ά.) απευθείας με την AI, με στόχο να πάρουν πιο “στοχευμένες” απαντήσεις σε ερωτήσεις σχετικά με την υγεία, αποτελέσματα εξετάσεων και άλλες πληροφορίες γύρω από την υγεία τους.

Η ιδέα ακούγεται χρήσιμη στην πράξη – μπορείς να ανεβάσεις ιστορικά στοιχεία, εργαστηριακές εξετάσεις ή να δώσεις πρόσβαση σε δεδομένα δραστηριότητας για να λάβεις στοχευμένες εξηγήσεις και συμβουλές. Ωστόσο, όπως τονίζει και η αναφορά του Ars Technica, υπάρχει μια σημαντική και ανησυχητική πτυχή: η AI μπορεί να “εφευρίσκει” πληροφορίες, ακόμα και όταν δουλεύει με πραγματικά δεδομένα υγείας .

Τι προσφέρει το ChatGPT Health

Το ChatGPT Health είναι σχεδιασμένο για να:

Συνδέει τα ιατρικά σου αρχεία και ιστορικό με το AI.

Συνδέει δεδομένα από εφαρμογές υγείας – ύπνος, δραστηριότητα, διατροφή – ώστε να παρέχει συνολική εικόνα.

Βοηθά να κατανοήσεις περίπλοκα ιατρικά αποτελέσματα ή να προετοιμαστείς για μια επίσκεψη στο γιατρό.

Παρέχει πληροφορίες, εξηγήσεις και γενικές κατευθύνσεις βάσει αυτών των δεδομένων .

Η εταιρεία ξεκαθαρίζει ότι δεν πρόκειται για εργαλείο αντικατάστασης γιατρό ή για διάγνωση/παρακολούθηση ασθενειών. Η ιδέα είναι να λειτουργεί ως συμπληρωματικό εργαλείο ενημέρωσης, όχι ως τελική ιατρική συμβουλή .

Το μεγάλο πρόβλημα: Hallucinations και ανακρίβειες

Το σημαντικό πρόβλημα που αναφέρεται είναι ότι, παρότι τα δεδομένα σου είναι “πραγματικά”, η AI συνεχίζει να παράγει απαντήσεις που φαίνονται πειστικές αλλά δεν είναι ακριβείς. Αυτό σημαίνει ότι μπορεί να:

Συσχετίσει στοιχεία με λάθος τρόπο.

Προτείνει διαγνώσεις ή συμπεράσματα που δεν υπάρχουν στα δεδομένα.

Εφευρίσκει ιατρικές λεπτομέρειες ή αναφορές που δεν είναι αληθείς.

Αυτό το φαινόμενο ονομάζεται hallucination και είναι κοινό στις γενετικές AI – δηλαδή το σύστημα δημιουργεί πλαστές, αλλά «λογικές» απαντήσεις λόγω του τρόπου που έχει εκπαιδευτεί .

Και αυτό είναι ιδιαίτερα επικίνδυνο όταν μιλάμε για γλώσσα γύρω από την υγεία, καθώς η λανθασμένη πληροφορία μπορεί να επηρεάσει σοβαρές αποφάσεις.

Γιατί συμβαίνει αυτό

Ακόμα και όταν βασίζονται σε πραγματικά προσωπικά δεδομένα, τέτοια συστήματα Τεχνητής Νοημοσύνης:

Λειτουργούν προβλέποντας την πιθανολογία και όχι επαληθεύοντας την κλινική αλήθεια.

Δεν έχουν ισχυρή πρόσβαση σε δομημένες, επαληθευμένες βάσεις ιατρικής γνώσης.

Μπορούν να συνδυάσουν μοτίβα από άσχετα συμφραζόμενα σε πειστικές αφηγήσεις.

Αυτό δεν είναι μόνο ένα θεωρητικό σφάλμα: είναι ένα από τα βασικά χάσματα που οι ερευνητές προσπαθούν να γεφυρώσουν πριν εφαρμόσουν AI σε ιατρικές χρήσεις με απαιτήσεις ασφάλειας και ακρίβειας υψηλότερες από έναν απλό χρήστη .

Τι σημαίνει αυτό για εσένα

Για τον απλό χρήστη, αυτό σημαίνει ότι:

Η δυνατότητα να συνδέεις τα δεδομένα σου με μια AI είναι βολική, αλλά δεν είναι απόλυτα αξιόπιστη.

Κάθε πληροφορία που λαμβάνεις από το ChatGPT Health πρέπει να ελέγχεται από γιατρό.

Οι «φιλικές» και πειστικές απαντήσεις της AI μπορεί να κρύβουν λάθη που θα μπορούσαν να οδηγήσουν σε λανθασμένες αποφάσεις.

Δεν υπάρχει ακόμα ένα σύστημα που να εξαλείφει πλήρως τις hallucinations σε ιατρικό πλαίσιο.

Συμπέρασμα

Το ChatGPT Health είναι μια σημαντική εξέλιξη στη χρήση AI για να κατανοούμε καλύτερα τα δεδομένα υγείας μας και να προετοιμαζόμαστε για ιατρικές συζητήσεις. Ωστόσο, ο ίδιος ο τρόπος που λειτουργεί η γενετική AI – προβλέποντας το πιο πιθανό και όχι το αληθινό – σημαίνει ότι ακόμα μπορεί να «εφευρίσκει» ιατρικές πληροφορίες. Για οποιαδήποτε απόφαση αφορά την υγεία σου, η συμβουλή ενός επαγγελματία γιατρού παραμένει απαραίτητη.

ΣΥΖΗΤΗΣΗ

Προσθήκη σχόλιου